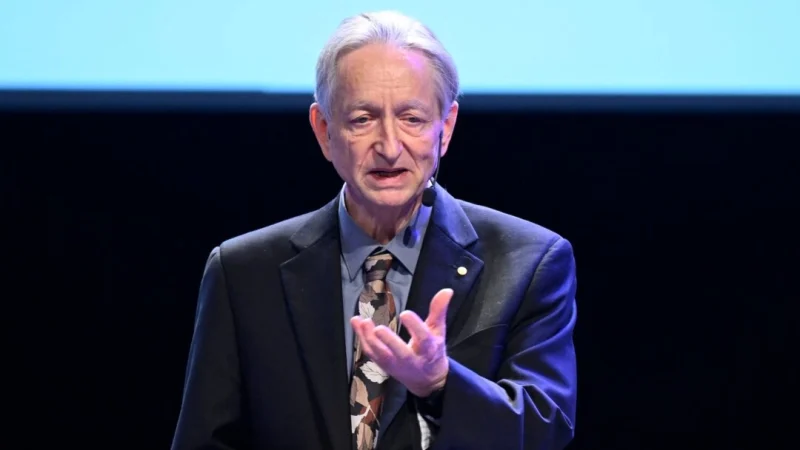

В интервью, опубликованном 18 августа в рамках предстоящего фильма «Создавая Бога», Хинтон выдвинул одно из своих самых суровых предупреждений. Он заявил, что человечество рискует оказаться на обочине, а в итоге и вовсе быть вытесненным машинами, гораздо более умными, чем люди.

«Большинство людей не способны постичь идею существования вещей, более разумных, чем мы», — сказал в видеоролике Хинтон, лауреат Нобелевской премии по физике и бывший руководитель Google.

«Они всегда думают: „Как мы будем использовать эту штуку?“ Они не думают: „Как она будет использовать нас?“»

Хинтон заявил, что он «вполне уверен», что искусственный интеллект приведёт к массовой безработице, указав на первые примеры того, как технологические гиганты, такие как Microsoft, заменяют младших программистов искусственным интеллектом. Но по его словам, главная опасность выходит далеко за рамки рабочих мест.

«Риск, о котором я предупреждал больше всего… это риск того, что мы разработаем ИИ, который будет намного умнее нас, и он просто возьмёт всё под свой контроль», — сказал Хинтон.

«Мы ему больше не понадобимся. Единственный положительный момент в том, что он нас не съест, потому что будет сделан из кремния», — добавил он.

От прорывов к сожалениям

77-летний Хинтон десятилетиями был пионером в области глубокого обучения — архитектуры нейронных сетей, лежащей в основе современных систем искусственного интеллекта. Его прорывы в 1980-х годах, в частности, изобретение машины Больцмана, способной обучаться распознавать закономерности в данных, открыли путь к распознаванию изображений и современному машинному обучению.

Эта работа принесла ему Нобелевскую премию по физике 2024 года, присуждаемую «за основополагающие открытия и изобретения, которые делают возможным машинное обучение с использованием искусственных нейронных сетей».

Королевская шведская академия наук отметила, что раннее использование Хинтоном статистической физики обеспечило концептуальный скачок, сделавший возможной современную революцию в области искусственного интеллекта.

Однако с тех пор Хинтон стал одним из самых ярых критиков этой области, предупреждая, что её стремительное развитие опережает возможности общества по обеспечению её безопасности. В 2023 году он ушёл со своего поста в Google, чтобы иметь возможность свободно говорить о рисках, не обвиняя компанию.

В своей Нобелевской лекции Хинтон признал потенциальные преимущества ИИ, такие как рост производительности и новые методы лечения, которые могут стать «чудесным достижением для всего человечества». Однако он также предупредил, что создание цифровых существ, более разумных, чем люди, представляет «экзистенциальную угрозу».

«Жаль, что я не подумал о вопросах безопасности», — сказал он на недавней конференции Ai4 в Лас-Вегасе.

Он отметил, что теперь сожалеет, что сосредоточился исключительно на обеспечении работоспособности ИИ, вместо того чтобы предвидеть связанные с этим риски.

Обучение ИИ заботе

Ранее Хинтон оценивал, что вероятность того, что ИИ может уничтожить человечество, составляет от 10 до 20%. В июньском эпизоде программы «Дневник генерального директора» он сказал, что инженеры, создающие современные системы ИИ, не до конца понимают технологию и в целом делятся на два лагеря: те, кто верит в антиутопическое будущее, где люди будут вытеснены, и те, кто отвергает подобные опасения как научную фантастику.

«Я думаю, что обе эти позиции являются крайними», — сказал Хинтон.

«Я часто говорю, что вероятность [у ИИ] уничтожить нас составляет 10–20%. Но это лишь интуиция, основанная на идее, что мы всё ещё создаём их и довольно изобретательны. И надежда в том, что если достаточно умных людей проведут необходимые исследования и будут располагать достаточными ресурсами, мы найдём способ создать их так, что они никогда не захотят причинить нам вред».

На конференции в Лас-Вегасе Хинтон предложил новую идею о том, как можно снизить опасность: вместо того чтобы пытаться заставить системы ИИ подчиняться, исследователи должны проектировать их с «материнскими инстинктами», чтобы они хотели защищать людей, становясь умнее.

«Правильная модель — это единственная имеющаяся у нас модель, в которой более разумное существо контролируется менее разумным существом, то есть матерью, контролируемой своим ребёнком», — сказал Хинтон на конференции.

«Они будут намного умнее нас», — предупредил Хинтон.

Он отметил, что «единственный хороший результат» будет, если они будут заботиться о человечестве так же, как мать заботится о своём ребёнке.

«Если он не станет моим родителем, он меня заменит».

__________

Чтобы оперативно и удобно получать все наши публикации, подпишитесь на канал Epoch Times Russia в Telegram